Si vous vous lancez dans le SEO ou simplement que vous cherchez à accroître la visibilité de votre site sur les moteurs de recherche, vous avez dû entendre parler d’algorithme Google. Ce nom barbare désigne simplement le fonctionnement sur lequel repose le moteur de recherche le plus connu. Très sophistiqué, il est tenu secret par la firme et il est donc très difficile de savoir réellement comment il classe les sites web dans ses pages de résultats. Mais, il y a quand même des infos dont on est sûrs et c’est ce que je vous dévoile aujourd’hui. À la fin de cet article, vous comprendrez mieux comment fonctionne le moteur de recherche Google et son algorithme.

Votre trafic SEO stagne et vous cherchez un moyen d’augmenter votre CA durablement ? Ma méthode a aidé des entreprises à augmenter jusqu’à 500% leur nombre de leads via le SEO.

Quel est l’algorithme de Google ?

L’algorithme de Google est un ensemble de règles et de critères utilisés par le moteur de recherche pour classer les pages web dans les résultats de recherche. À l’origine, cet algorithme reposait sur le PageRank, concept inventé par Larry Page, le créateur de Google, et qui se basait sur le nombre de liens externes que recevait une page pour définir sa pertinence.

Ce PageRank existe toujours, mais ce n’est plus le cœur de l’algorithme. Il existe aujourd’hui une tonne d’autres critères (tenus secrets) sur lesquels Google se base pour juger si une page web est pertinente ou non. Et, d’ailleurs, il existe plusieurs algorithmes au sein de l’algorithme Google, ou plutôt « systèmes » comme il aime les appeler. Voici les principaux et en quoi ils consistent.

PageRank (1998)

Conçu pour classer les pages Web en fonction de leur importance, déterminée par le nombre et la qualité des liens pointant vers elles.

Panda (2011)

Lancé pour lutter contre les sites Web de faible qualité et le contenu dupliqué ou peu original, en évaluant la qualité du contenu et en attribuant un score de qualité à chaque page Web.

Penguin (2012)

Visant à pénaliser les sites utilisant des tactiques de manipulation de liens (linkbuilding) pour améliorer leur classement, en évaluant la qualité des liens pointant vers un site.

Hummingbird (2013)

Conçu pour mieux comprendre le contexte et l’intention derrière les requêtes de recherche, en particulier pour les requêtes conversationnelles et les questions.

Pigeon (2014)

Amélioration de la pertinence et de la précision des résultats de recherche locale, en tenant compte de la proximité physique de l’utilisateur par rapport à l’emplacement des entreprises listées.

RankBrain (2015)

Utilisation de l’intelligence artificielle pour améliorer la compréhension des requêtes de recherche, en particulier pour les requêtes jamais vues auparavant.

Mobilegeddon (2015)

Favorise les sites Web optimisés pour les mobiles dans les résultats de recherche sur les appareils mobiles.

Possum (2016)

Modifications significatives pour offrir une plus grande diversité de résultats en tenant compte de la proximité physique de l’utilisateur par rapport à l’emplacement des entreprises listées.

Fred (2017)

Ciblait principalement les sites Web enfreignant les consignes de Google en matière de qualité de contenu, en particulier ceux surchargés de publicités et de faible qualité.

Systèmes de déduplication

Les recherches sur Google peuvent générer de nombreuses pages Web similaires, mais seuls les résultats les plus pertinents sont affichés pour éviter les doublons. La déduplication s’applique également aux extraits optimisés (featured snippet, par exemple), ce qui permet d’épurer les résultats et de faciliter la recherche d’informations pertinentes pour les internautes.

Par exemple, si une page se classe en featured snippet, on ne la retrouve pas ailleurs dans les résultats.

Exact match domain system

Ce système veille à ne pas accorder trop de crédit au contenu hébergé sous des domaines conçus pour correspondre exactement à des requêtes particulières. Exemple d’un nom de domaine Exact Match (ou EMD) : « seche-cheveux-rose.fr ».

Le système Freshness (fraîcheur)

Cet algorithme est conçu pour afficher du contenu plus récent pour les requêtes où c’est attendu, en particulier pour les thématiques d’actualité.

BERT (2019)

Basé sur l’intelligence artificielle pour améliorer la compréhension du contexte et de l’intention derrière les requêtes de recherche.

Core Web Vitals (2020)

Nouvelles métriques conçues pour mesurer les performances de chargement, l’interactivité et la stabilité visuelle des pages Web.

Product Reviews (2021)

Cet algo vise à identifier et mettre en avant les avis authentiques dans la recherche, donc privilégier les personnes qui démontrent une réelle expérience.

Helpful Content (2022)

Cet algorithme de Google vise à récompenser les pages offrant une expérience positive aux utilisateurs, en identifiant automatiquement les contenus peu intéressants (inutiles) ou à faible valeur ajoutée. Ce système génère un signal à l’échelle du site, pris en compte parmi de nombreux autres signaux dans le classement des résultats de recherche.

Il fonctionne à l’aide d’un modèle de machine learning, évaluant la pertinence et l’utilité du contenu. Les sites publiant principalement des informations sans valeur ajoutée auront donc moins de chances d’être bien classés. Si un site supprime le contenu inutile, le signal peut rester appliqué pendant plusieurs mois, mais une amélioration peut être constatée une fois que le contenu a été amélioré.

Lis mon article pour en savoir plus sur HCU et comment lever sa pénalité !

Bon à savoir : sur son site officiel, Google explique ne plus utiliser les algorithmes Panda, Hummingbird et Penguin. Mais, vous apprendrez qu’il ne faut pas toujours croire ce que dit Google…

Comment fonctionne le moteur de recherche Google ?

Le fonctionnement du moteur de recherche de Google peut être divisé en trois étapes clés : le crawling, l’indexation et le classement.

Crawling

Cette première étape implique l’utilisation de Googlebot, également connus sous le nom de « spiders », qui parcourent le Web pour trouver de nouvelles pages et sites. Ils suivent les liens de page en page et collectent les informations qu’ils trouvent pour les rapporter à Google.

Indexation

Une fois que les Googlebots ont récupéré les pages web, celles-ci sont analysées et indexées. Cela signifie que Google examine le contenu de chaque page, y compris le texte, les images, les vidéos, etc., ainsi que la structure du site, les méta-données et d’autres facteurs pour comprendre de quoi parle la page.

La page est ensuite stockée dans l’index de Google, qui est une immense base de données de toutes les pages web qu’il a trouvées.

Classement

Lorsqu’une personne effectue une recherche, Google explore son index pour trouver les pages les plus pertinentes pour cette requête. Il classe ces pages en fonction de plus de 200 facteurs (qui composent ses fameux algorithmes), dont la pertinence du contenu par rapport à la requête, la confiance attribuée à la page, l’expérience utilisateur sur la page, les backlinks et bien d’autres.

Votre trafic SEO stagne et vous cherchez un moyen d’augmenter votre CA durablement ? Ma méthode a aidé des entreprises à augmenter jusqu’à 500% leur nombre de leads via le SEO.

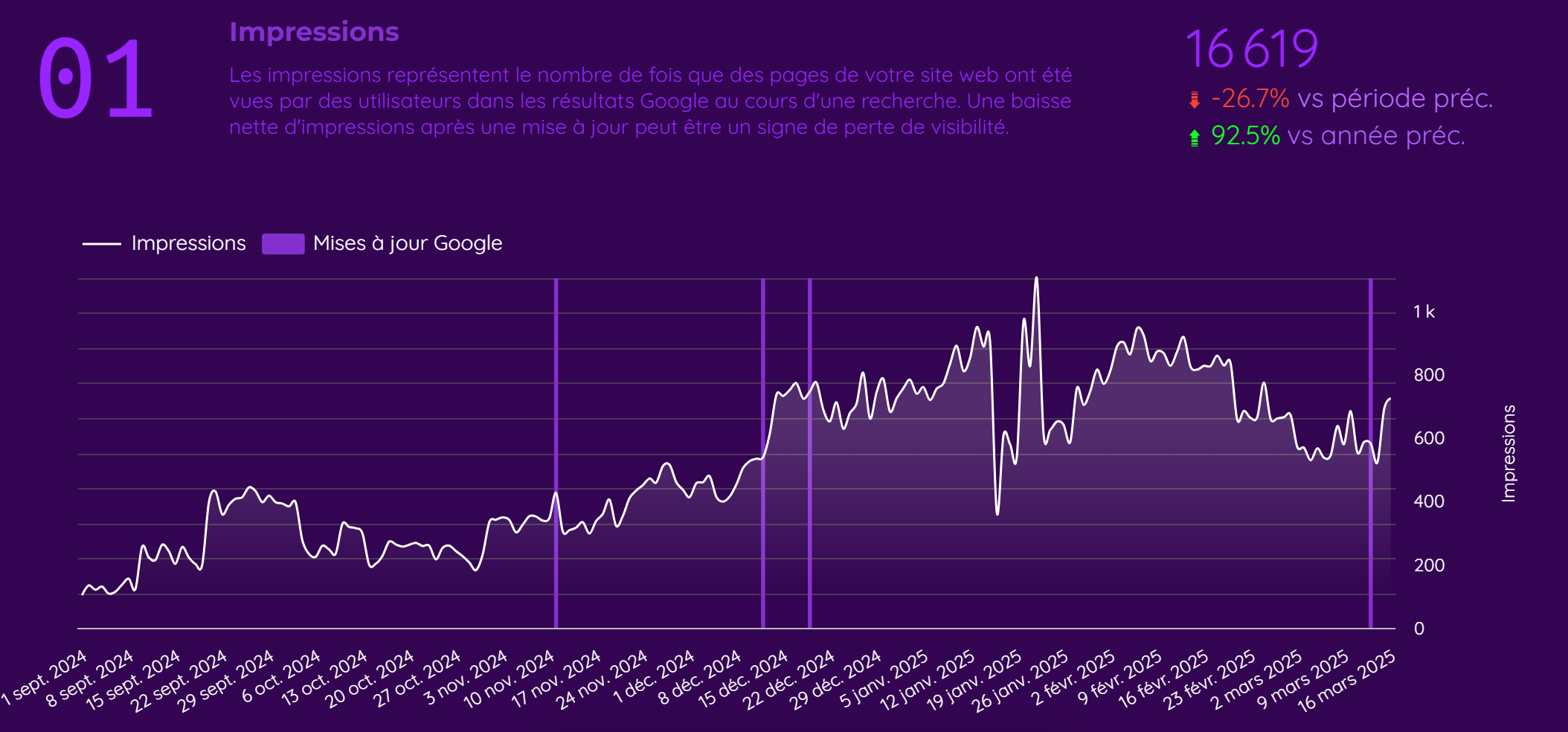

Combien de fois l’algorithme Google est-il mis à jour ?

L’algorithme de Google est mis à jour des centaines de fois par an. Ces mises à jour peuvent être mineures ou majeures, et visent à améliorer la pertinence et la qualité des résultats de recherche pour les utilisateurs. Certaines mises à jour sont annoncées publiquement par Google, tandis que d’autres sont plus discrètes.

Mais, seules les importantes mises à jour (appelées Core Update) changent radicalement la manière dont le moteur de recherche classe les sites web. La dernière mise à jour importante a été une Helpful Content Update (HCU) en septembre 2023.

Au total, on estime le nombre de mises à jour majeures à 3 à 5 fois par an. Vous pouvez retrouver le détail de celles-ci dans la page dédiée à l’évolution de la recherche sur le site de Google.

Quels sont les critères inclus dans cet algorithme ?

Google ne communique pas officiellement sur le nombre et la nature des facteurs de classement de son moteur de recherche. Ce serait trop facile, non ? 👀 C’est d’ailleurs ce qui rend le SEO si intéressant selon moi…

Toutefois, les dizaines d’années d’expérience et de test de toute la communauté SEO ont permis d’identifier la majorité des critères de référencement de Google. Certains ont même été « confirmés » par des représentants de Google (en particulier John Mueller, le principal porte-parole), mais, une fois encore, il faut s’en méfier car cela peut aussi servir à brouiller les pistes ! 🥵

En bref, les critères inclus dans l’algorithme de Google sont très nombreux et plutôt opaques. Néanmoins, une chose est certaine : ces facteurs visent toujours à fournir les résultats les plus pertinents et les plus fiables aux utilisateurs.

Vous trouverez des listes très complètes de l’ensemble de ces présumés facteurs sur des sites comme Backlinko, Ahrefs ou encore HubSpot. Pour résumer, ces critères peuvent être classés en plusieurs catégories principales :

- Contenu de qualité : Google privilégie le contenu riche, informatif et original. La pertinence du contenu par rapport à la requête de recherche, la couverture exhaustive du sujet, et l’utilisation de mots-clés pertinents.

- Expérience utilisateur (UX) : la vitesse de chargement des pages, la compatibilité mobile ou encore la facilité de navigation seraient des critères essentiels pour un bon classement. L’expérience sur mobile est d’ailleurs particulièrement scrutée, Google ayant adopté une approche Mobile-First depuis quelques années (il crawle un site dans sa version mobile en priorité).

- Liens entrants (backlinks) : la quantité et la pertinence des backlinks figurent encore aujourd’hui parmi les facteurs les plus importants. Les liens provenant de sites de forte autorité dans la même thématique sont particulièrement valorisés.

- Facteurs techniques : l’architecture du site, la sécurité (HTTPS), la structuration des données (schema markup), et l’optimisation du crawl par les robots de recherche jouent également un rôle important (d’autant plus pour les gros sites web).

- Signaux sociaux et branding : la présence de la marque sur les réseaux sociaux et ses mentions sur le web peuvent aussi influencer indirectement le classement, même si leur impact direct soit sujet à débat.

- Comportement des utilisateurs : beaucoup sont persuadés que Google utilise des indicateurs comme le CTR (taux de clic), le temps passé sur le site ou les interactions sur la page pour mieux cerner la qualité du contenu et de l’UX.

Débutant en SEO ? Je vous invite aussi à parcourir mon glossaire du SEO pour mieux maîtriser le vocabulaire !

Comment fonctionne l’algorithme des avis Google ?

Lorsqu’on parle d’avis, on fait référence aux avis laissés par les utilisateurs sur les fiches Google Business Profile des entreprises. Ces avis sont très clairement l’un des facteurs de classement les plus importants pour le référencement local (référencement dans une zone géographique précise). De la même manière que les backlinks qui pointent vers un site web, les avis clients transmettent beaucoup d’informations à Google sur la nature de l’activité de l’entreprise et sa fiabilité.

Ainsi, une entreprise ayant beaucoup d’avis positifs sera privilégiée par rapport à un concurrent avec très peu d’avis, essentiellement négatifs. De même, si ces avis contiennent des mots-clés en relation avec la requête tapée par l’internaute, l’entreprise aura plus de chances de se classer dans les premiers résultats de la SERP (ou de Google Maps).

Peut-on manipuler les résultats de recherche Google ?

Oui, on peut manipuler les résultats de recherche Google, et c’est d’ailleurs tout l’intérêt du SEO 😆 (cf mon article sur C’est quoi le SEO ?). En fait, dès lors que vous mettez en place des actions dans le but d’apparaître dans les premiers résultats, vous tentez d’une certaine manière de manipuler l’algorithme.

Alors, bien sûr, il y a plusieurs degrés de manipulation. Le niveau 0 fait référence aux techniques appelées WhiteHat. Les personnes qui utilisent des méthodes SEO WhiteHat ont très peu de risque d’être un jour pénalisé par Google dans la mesure où ils se contentent de suivre les guidelines de ce dernier. C’est-à-dire qu’il faut faire en sorte de fournir le meilleur contenu et la meilleure expérience, ce qui permettra d’acquérir une popularité naturellement 😉.

Soyons réalistes : il est extrêmement rare de ne faire que du WhiteHat. Par exemple, dès lors que vous payez pour obtenir des backlinks ou que vous faites un échange, vous êtes en dehors de la limite. Or, il s’agit là d’une pratique très courante et (si elle est bien faite) peu risquée.

À l’opposé du WhiteHat on retrouve (très logiquement) le BlackHat SEO. C’est un peu la partie sombre du SEO dans laquelle les éditeurs de site s’amusent avec des techniques pas toujours légales pour être dans les premiers résultats.

Je grossis le trait, bien sûr. En réalité, ce n’est pas parce-que vous allez à l’encontre des règles de Google que vous êtes hors-la-loi ! Mais, certaines pratiques sont, en effet, répréhensibles (vol de contenu, hacking, etc.).

En réalité, l’essentiel des experts SEO peut se ranger dans la catégorie GreyHat. Vous l’avez compris, c’est un mix de WhiteHat et de BlackHat.

Peut-on se faire pénaliser par l’algo de Google ?

Oui, il est possible de se faire pénaliser par l’algorithme de Google, de manière volontaire ou involontaire. Le résultat est le même : la visibilité de votre site sur le moteur de recherche est clairement affectée (jusqu’à la disparition totale du site sur Google dans les pires cas).

Les pénalités Google peuvent survenir de deux manières :

- Pénalité manuelle (sanction) : suite à la violation des directives de Google (backlinks non naturels, cloaking, texte ou liens cachés, etc.). Cette pénalité est le résultat d’une révision par l’équipe de Google, suite à une dénonciation par exemple.

- Pénalité algorithmique : elle est automatiquement appliquée par des mises à jour spécifiques de l’algorithme, comme Panda (pour le contenu de faible qualité) et Penguin (pour les profils de liens artificiels). En d’autres termes, Google renforce la précision de son algorithme et si votre site web ne répond pas aux nouvelles exigences, il en fait les frais.

Pour sortir d’une pénalité manuelle, il est essentiel de corriger les problèmes signalés par Google, et de soumettre une demande de réexamen une fois les corrections effectuées.

Quant à l’impact suite à une mise à jour, il faudra faire un travail d’analyse approfondi pour identifier les actions à mener sur le site. En général, il faudra attendre plusieurs mois avant de retrouver le trafic d’antan, parfois même jusqu’à la prochaine mise à jour majeure.

Vous avez été victime d’une chute de trafic suite à une mise à jour Google ? J’ai déjà accompagné de nombreuses entreprises à retrouver leur visibilité, il vous suffit de me contacter pour obtenir un devis :

Attention, ce n’est pas parce-que vous ne trouvez pas votre site dans les pages de résultats que vous avez été pénalisé. Cela peut simplement être le résultat d’une mauvaise optimisation de votre site web ! Utilisez l’un des outils que je recommande pour connaître la position de votre site sur Google afin d’en avoir le cœur net.

Comment Google s’assure-t-il de la pertinence de son algorithme ?

Pour améliorer la pertinence de son algorithme, Google passe par un processus continu d’évaluation, de test et de mise à jour. Plus concrètement, la firme combine des approches technologiques avec des évaluations humaines.

D’un côté, Google utilise l’apprentissage automatique et l’intelligence artificielle pour analyser les tendances de recherche, comprendre le langage naturel et identifier les signaux de qualité des contenus.

Google procède également à des milliers d’expériences et de tests A/B chaque année, pour améliorer son moteur de recherche en fonction des comportements des utilisateurs et des feedbacks reçus.

De l’autre, le moteur de recherche emploie des Quality raters, qui suivent des directives strictes (listées dans le guide Search Quality Evaluator Guidelines) pour évaluer la pertinence et la qualité des résultats de recherche. Ces personnes ne modifient pas directement les classements, mais leurs évaluations fournissent des retours précieux pour ajuster et améliorer l’algorithme.

Bon à savoir : Google tend à devenir un moteur de réponse tant il intègre de fonctionnalités pour donner une réponse instantanée. Cela conduit inévitablement à une tendance haussière des requêtes à zéro clic.

Comment l’algorithme de Google lutte-t-il contre le spam ?

Il existe une équipée dédiée à la lutte contre le spam chez Google, qu’on appelle aussi le spamdexing. Cette équipe est chargée de détecter les nouvelles formes de spam utilisées par les éditeurs de site pour manipuler les résultats de recherche, et de trouver comment les contourner.

Par ailleurs, Google encourage la communauté en ligne à signaler le spam via la Google Search Console et son outil de désaveu des liens (backlinks de mauvaise qualité). Néanmoins, de nombreux experts SEO sont d’accord pour dire que cette pratique est inutile dans la mesure où Google est capable de faire le tri lui-même.

Laisser un commentaire

Vous devez vous connecter pour publier un commentaire.